2025 год стал рекордным по количеству дипфейков - искусственно созданных видео и аудио, где лица, голоса и движения людей выглядят почти как настоящие.

Если в 2023 году в мире насчитали около 500 тысяч дипфейков, то в 2025 их уже около 8 миллионов - рост почти 900 % за два года.Но что делает эти технологии настолько опасными и правдоподобными?

Читайте нас также

Почему современные дипфейки так убедительны

Движения и мимика

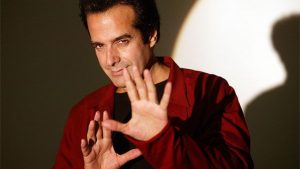

Сейчас ИИ умеет имитировать не только лицо, но и движения тела. Например, один и тот же жест руки можно приложить к разным людям, а одна и та же персона может двигаться по-разному в разных видео. Изображения больше не мерцают и не искажаются, как это было раньше.Клонирование голоса

Чтобы создать правдоподобный голос, достаточно всего нескольких секунд записи. Клон повторяет интонации, эмоции, акценты и даже паузы дыхания. Представьте, что кто-то присылает вам аудиосообщение от «друга» - на самом деле это может быть полностью сгенерированная запись.Простота создания

Раньше, чтобы сделать дипфейк, нужны были навыки в видеомонтаже и программировании. Сейчас любой человек может воспользоваться инструментами вроде OpenAI Sora 2 или Google Veo 3, составить сценарий через ChatGPT или Google Gemini и через несколько минут получить готовое видео. Автоматизация процесса через ИИ‑агентов позволяет создавать целые серии роликов без участия человека.

Дипфейки уже применяют для:

Дезинформации - например, фейковые заявления политиков в соцсетях.

Финансовых махинаций - подделка голоса руководителя для перевода денег.

Читайте

Преследования людей - фальшивые видео с участием жертв.

Простым людям сложно отличить такие материалы от настоящих, а проверка информации не успевает за скоростью распространения.

Что ждёт нас в будущем

2026 год обещает быть еще более впечатляющим (и опасным) по внедрению дипфейков. Технологии движутся в сторону:

Генерации в реальном времени - лица и голоса людей будут синтезироваться на лету во время видеозвонков.

Полной имитации манер и поведения - персонажи будут вести себя как их реальные прототипы.

То есть мошенники смогут показывать «живые» ИИ‑аватары вместо записанных роликов. Чтобы защититься, одного внимания к мелочам уже мало - потребуются технические методы: криптографическая подпись настоящих материалов, маркировка контента, созданного ИИ.

Дипфейки 2025 года показывают, насколько быстро технологии ИИ становятся частью нашей повседневной жизни. Они могут удивлять и развлекать, но одновременно создают новые риски для информации, безопасности и доверия. Пока человечество ищет способы распознавать подделки и защищать себя, очевидно одно: границы между реальным и искусственным контентом стираются, и нам предстоит учиться ориентироваться в мире, где почти все может быть создано машиной