Папа Римский Франциск обратился к лидерам саммита G7, став первым понтификом, принявшим участие в подобной встрече.

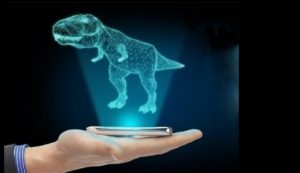

Выступая в рамках специального круглого стола, Франциск призвал лидеров обеспечить защиту человеческого достоинства при разработке и использовании искусственного интеллекта. Он предупредил, что столь мощные технологии могут привести к превращению человеческих отношений в алгоритмы.

«Перед лицом чудес машин, которые, кажется, умеют выбирать самостоятельно, мы должны четко осознавать, что принятие решений, даже когда мы сталкиваемся с их порой драматическими и неотложными аспектами, всегда должно оставаться за человеком», — сказал он.

«Мы обречем человечество на будущее без надежды, если отнимем у людей способность принимать решения относительно себя и своей жизни, обрекая их на зависимость от выбора машин», — добавил понтифик.

При этом он предложил этический взгляд на проблему, которая все чаще фигурирует в повестке дня международных саммитов и заседаний на национальном уровне.

Понтифик заявил, что политики должны взять на себя инициативу в обеспечении того, чтобы ИИ оставался ориентированным на человека, чтобы решения о применении оружия или даже менее смертоносных инструментов всегда принимались людьми, а не машинами.

Говоря об автономном оружии, он заявил, что решение о том, убивать человека или нет, никогда не должно оставаться за машинами.

Итоговое заявление G7 в значительной степени отразило его опасения. Лидеры пообещали лучше координировать управление и нормативно-правовую базу, окружающую ИИ, чтобы он был «ориентирован на человека».

В то же время они признали потенциальное влияние на рынки труда машин, которые заменят людей, и на систему правосудия — алгоритмов, предсказывающих рецидив преступлений.

«Мы будем стремиться к инклюзивной цифровой трансформации, ориентированной на человека, которая способствует экономическому росту и устойчивому развитию, максимизирует выгоды и управляет рисками в соответствии с нашими общими демократическими ценностями и уважением к правам человека», — заявили они.